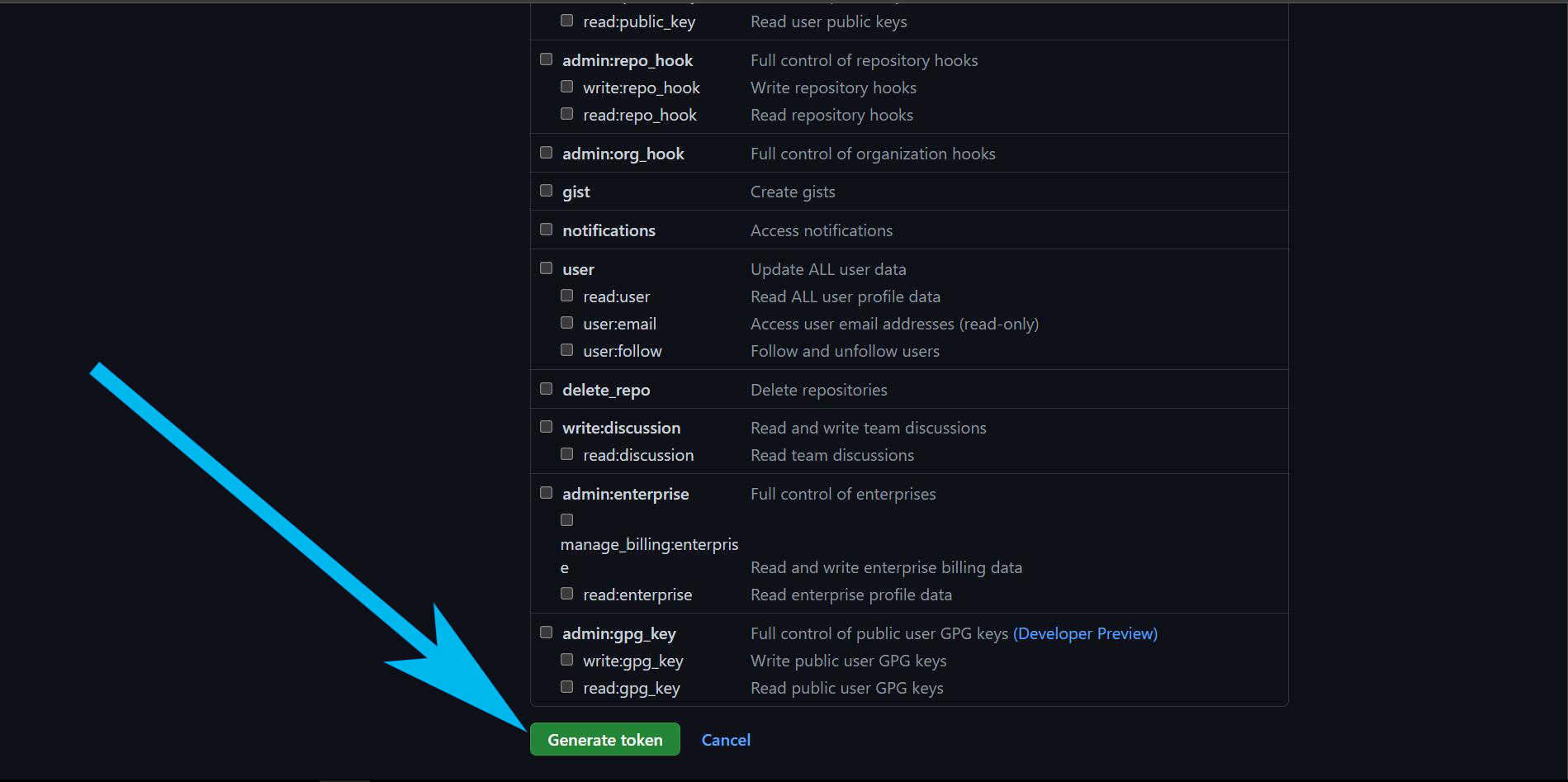

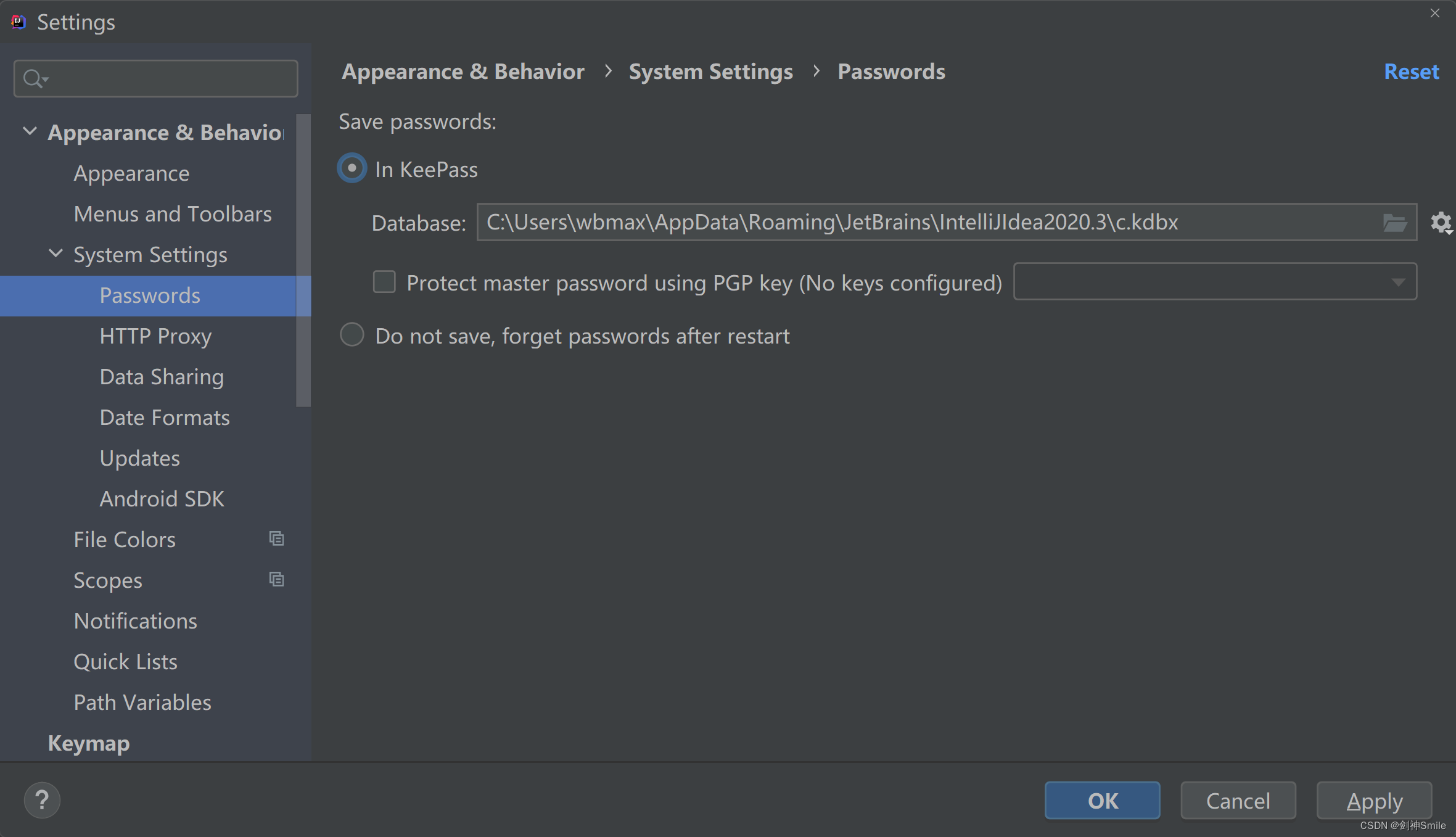

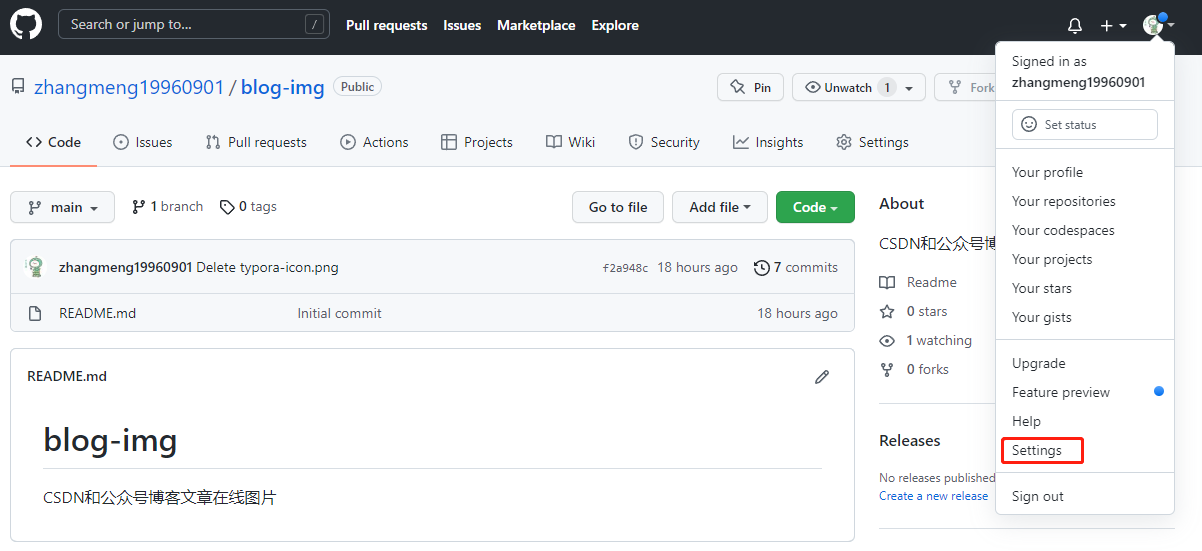

github token_github token

*** 次数:1999998 已用完,请联系开发者***

ˋωˊ GitHub热榜第一:百万token上下文,还能生成视频,UC伯克利出品克雷西 发自 凹非寺量子位 | 公众号 QbitAI今日GitHub热榜榜首,是最新的开源世界模型。上下文窗口长度达到了100万token,持平了谷歌同时推出的王炸Gemini 1.5,伯克利出品。强大的模型,命名也是简单粗暴——没有任何额外点缀,直接就叫LargeWorldModel(LWM)。LWM支持处理多模...

400万token上下文、推理再加速46%!最新开源方案升级MIT成果实现多轮对话共400万个token,22.2倍推理速度提升。该项目在上线不到3个月时间内,GitHub项目标星达到5.7k star。不过,StreamingLLM使用原生PyTorch实现,对于多轮对话推理场景落地应用的低成本、低延迟、高吞吐等需求仍有优化空间。Colossal-AI团队开源了SwiftInfer,基于Tenso...

北大字节开辟图像生成新范式!超越DiT,不再预测下一个token鱼羊 发自 凹非寺量子位 | 公众号 QbitAI北大和字节联手搞了个大的:提出图像生成新范式,从预测下一个token变成预测下一级分辨率,效果超越Sora核心组件Diffusion Transformer(DiT)。并且代码开源,短短几天已经揽下1.3k标星,登上GitHub趋势榜。具体是个什么效果?实验数据上,这个名...

(^人^)

Hugging Face 现 API 令牌漏洞,黑客可获取微软谷歌等模型库权限因此黑客可以直接从 Hugging Face 及 GitHub 的存储库(repository)获得平台上各模型分发者的 API 令牌(token),安全人员一共从上述平台中找到 1681 个有效的令牌。▲ 图源 安全公司 Lasso Security经过一步分析资料,安全人员获得了 723 家企业组织的帐号,其中包括 Meta、微软、谷歌...

贾佳亚韩松团队新作:两行代码让大模型上下文窗口倍增克雷西 发自 凹非寺量子位 | 公众号 QbitAI只要两行代码+11个小时微调,就能把大模型4k的窗口长度提高到32k。规模上,最长可以扩展到10万token,一口气就能读完一本小说。贾佳亚韩松联合团队提出的这个基于LoRA的全新大模型微调方法,登上了GitHub热榜。这种方式叫做LongLoRA...

≥﹏≤ StreamingLLM 框架问世,号称“可让大模型处理无限长度文本”获取 token 的键(Key)值(Value)状态会消耗大量的 RAM。第二个挑战:目前流行的大语言模型,难以泛化适用“超过训练序列长度”的长文本。IT之家注意到,过去有许多研究试图解决上述挑战,像是“扩展注意力窗口”,让语言模型能够处理超出预训练序列长度的长文本;或是建立一个固定...

蓝鲸加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:github token

下一篇:github token在哪